[Home] AI로 돌아가기

🔗 관련 문서:

Wikipedia - ROC AUC

AUC (Area Under the ROC Curve)

AUC는 이진 분류(Binary Classification) 모델의 성능을 평가하는 지표로, ROC 곡선 아래의 면적을 나타낸다.

0에서 1 사이의 값을 가지며, 값이 클수록 모델의 분류 성능이 우수함을 의미한다.

(1) 정의와 핵심 개념

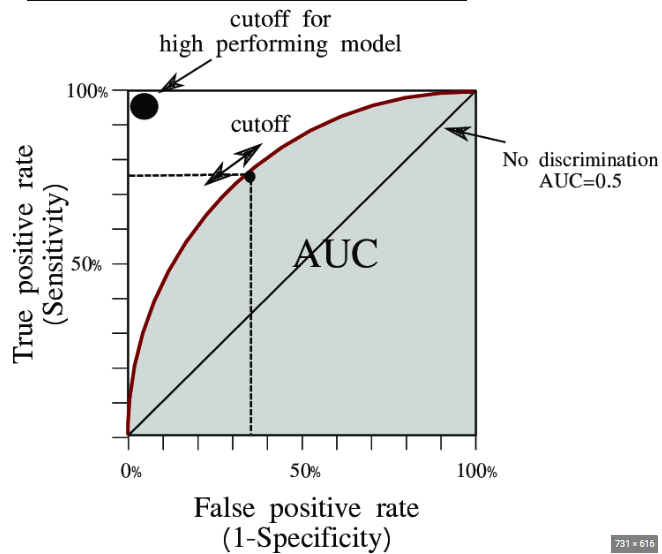

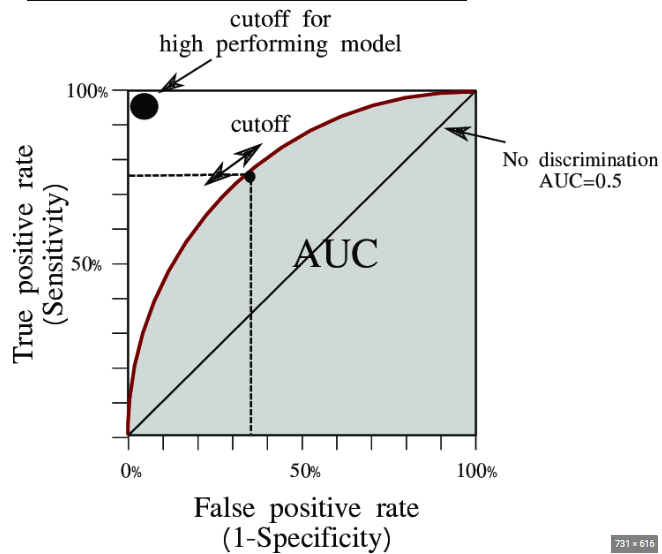

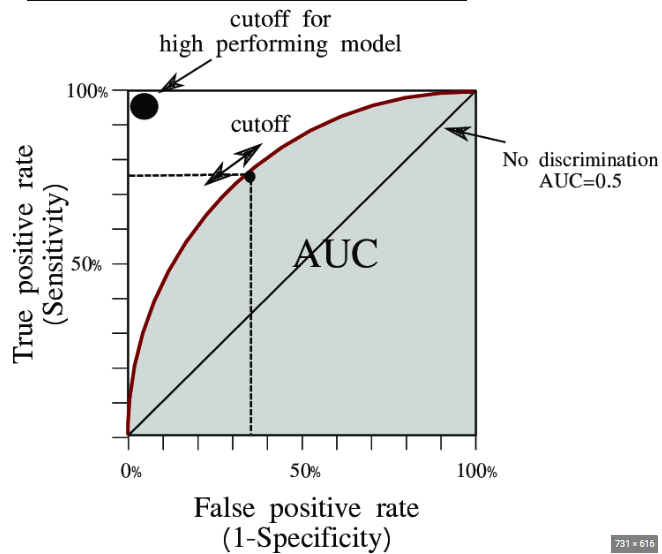

AUC(Area Under the Curve)는 ROC(Receiver Operating Characteristic) 곡선 아래의 면적을 측정한 값이다.

ROC 곡선은 True Positive Rate(TPR, 민감도)를 Y축으로, False Positive Rate(FPR)를 X축으로 하여 분류 임계값(threshold)의 변화에 따른 성능을 시각화한 그래프이다.

AUC는 모델이 양성 샘플을 음성 샘플보다 높은 확률로 분류할 가능성을 나타내며, 임계값에 독립적인 평가를 제공한다.

(2) 계산 원리

- 분류 모델이 각 샘플에 대해 예측 확률을 출력한다.

- 다양한 임계값에 대해 TPR과 FPR을 계산한다.

- TPR = TP / (TP + FN) : 실제 양성 중 올바르게 예측한 비율

- FPR = FP / (FP + TN) : 실제 음성 중 잘못 예측한 비율

- 각 임계값에서의 (FPR, TPR) 좌표를 연결하여 ROC 곡선을 그린다.

- 이 곡선 아래의 면적을 적분하여 AUC 값을 구한다.

(3) 해석 방법

AUC 값의 의미는 다음과 같이 해석된다.

- AUC = 1.0 : 완벽한 분류 모델

- 0.9 ≤ AUC < 1.0 : 매우 우수한 모델

- 0.8 ≤ AUC < 0.9 : 좋은 모델

- 0.7 ≤ AUC < 0.8 : 괜찮은 모델

- 0.6 ≤ AUC < 0.7 : 나쁜 모델

- AUC = 0.5 : 무작위 분류기 수준

- AUC < 0.5 : 무작위보다 못한 모델 (예측을 반대로 하면 개선됨)

(4) 장점과 한계

장점

- 임계값 독립적 : 특정 임계값 선택 없이 전반적인 성능 평가 가능

- 불균형 데이터에서도 비교적 안정적인 평가 제공

- 단일 수치로 모델 성능을 직관적으로 비교 가능

- 모델 간 상대적 비교가 용이함

한계

- 심한 클래스 불균형 상황에서는 PR-AUC(Precision-Recall AUC)가 더 적합할 수 있음

- AUC가 높아도 특정 임계값에서의 성능은 낮을 수 있음

- 비용이 다른 오분류(FP와 FN의 비용 차이)를 구분하지 못함

- 단일 수치이므로 모델의 세부적인 성능 특성을 파악하기 어려움

(5) 개념도

다음은 ROC 곡선과 AUC를 시각적으로 나타낸 예시이다.

Area Under the Curve (AUC): A Robust Performance Measure of Classification Models

Area Under the Curve (AUC): A Robust Performance Measure of Classification Models

출처: https://medium.com/