또한, 인공지능의 오류를 수정하려면 인공지능이 결과를 판단하는 근거 및 이유를 알아야 한다.

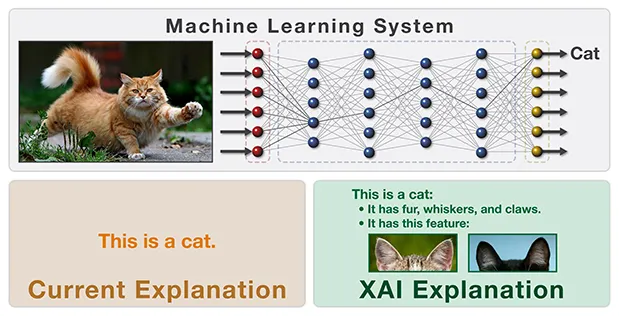

설명가능 인공지능은 인공지능 시스템이 도출한 예측 결과와 그 과정을 인간이 이해할 수 있도록 해서 이런 문제를 해결한다.

출처: https://v.daum.net/v/9QRkXAWAqi

🔗 관련 문서: Wikipedia - Explainable Artificial Intelligence

Q) 책임 있는 AI(Responsible AI)란 어떤 AI인가?

A) 신뢰성 있는 AI!

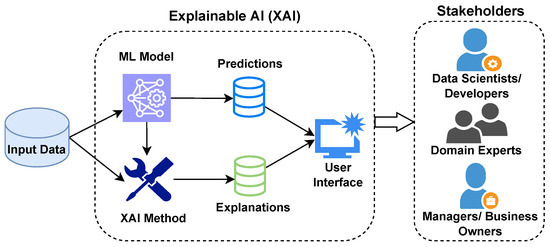

설명가능 인공지능(XAI; eXplainable AI)은 AI의 예측이나 의사결정 과정을 인간이 이해할 수 있도록 설명해주는 기술 또는 방법론을 의미한다. 특히 딥러닝처럼 복잡한 모델의 결정 논리를 해석 가능하게 만들어 신뢰성, 투명성, 책임성을 확보하려는 목적이 있다.

XAI(Explainable AI)는 인공지능의 판단 과정이 "왜 그런 결과를 도출했는가?"에 대한 답변을 할 수 있도록 하는 접근이다.

특히 의료, 법률, 금융, 국방과 같은 분야에서는 AI의 투명한 설명이 필수적이며, 설명 불가능한 AI는 신뢰받기 어렵다.

가. 모델 본연 설명 (Interpretable Models)

나. 사후 설명 기법 (Post-hoc Explanation)

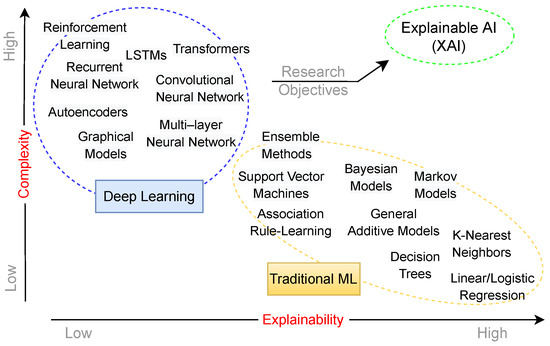

일반적으로 설명 가능한 모델일수록 구조가 단순하므로 정확성은 낮을 수 있다. 반면, 높은 정확성을 가진 딥러닝 모델은 설명이 어렵다.

따라서 정확성과 설명성 사이의 균형을 고려하여 분야별로 적절한 AI 모델을 선택해야 한다.

1) 기술적 관점

2) 비즈니스 관점

3) 법과 제도적 관점

4) 인공지능 산업 관점

의료 분야의 경우 당뇨병성 망막병증을 진단하고 병변을 검출하는 컴퓨터 보조 검출 시스템이 소개된 바 있다. 네덜란드의 한 안과 연구진의 연구 사례로 망막 기저부의 이미지를 입력 데이터로 사용하면, 건강한 망막을 자동으로 감지하고 병이 진행되고 있는 망막의 이미지를 선별해 안과 전문의를 돕는 보조 시스템이다. 이 시스템은 의심스러운 국소 병변을 안과의와 함께 검사할 수 있는 대화형 도구를 제공하여, 인공지능의 의사결정을 신뢰할 수 있도록 돕는다는 데에 의의가 있다.

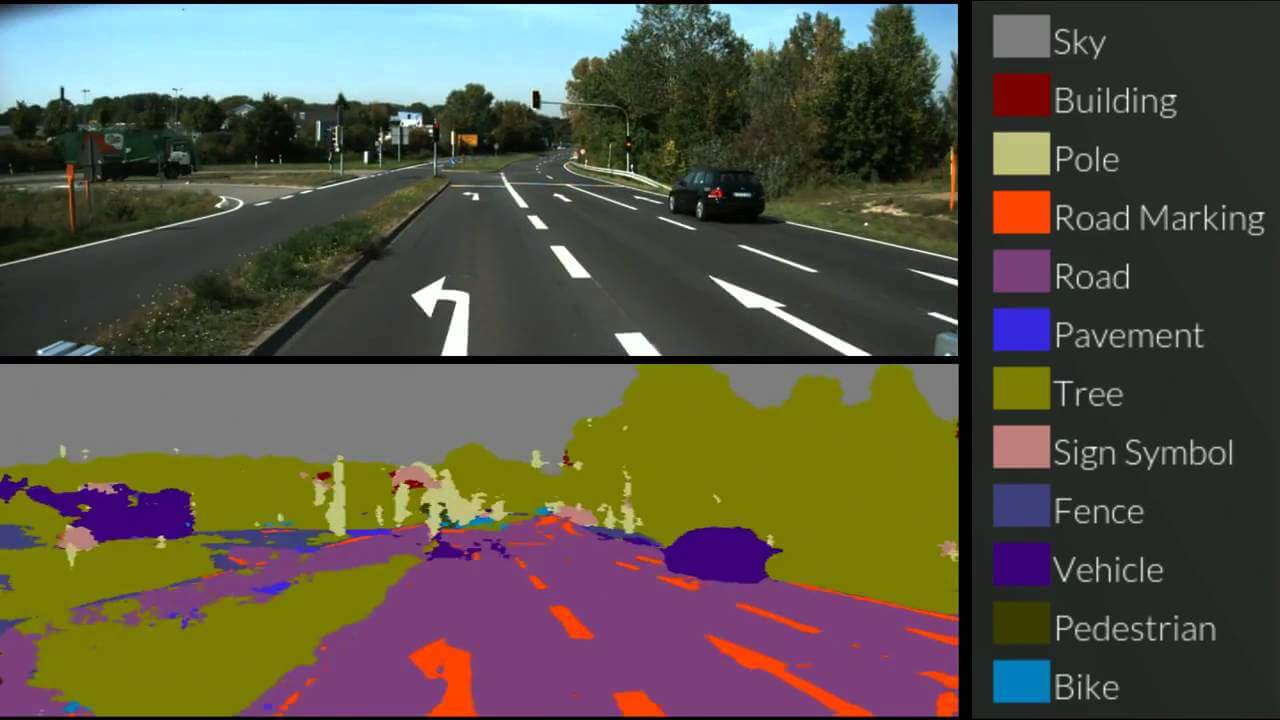

자율주행의 영역에서도 NDRT(Non-Driving Related Task) 상황에서 인공지능이 상황 제어권을 가지고 있다는 것을 어떻게 운전자에게 설명할 것인지, 그런 상황들을 어떻게 분류하고 짧은 시간 내에 효율적으로 전달할 것인지에 대한 연구도 XAI의 영역이라고 할 수 있다. 자율주행의 특성상 운전자와 실시간으로 상호에 대한 interaction이 필요하기 때문에 운전자에게 전달하기 위한 설명 인터페이스를 개발하는 User eXperience와 인터페이스 영역까지 확대되어 있는 분야라고 할 수 있다.

미국 심머신(simMachines, Inc.)이 개발·공급하는 AI 심머신(AI simMachines)은 XAI의 일종이다. 이 솔루션은 소비자 행동에 영향을 미치는 빅데이터에 기반하여, 기업의 패턴을 감지하고 미래의 수요 또는 소비를 예측하며 과거의 추이를 가시화한다. 심머신의 솔루션은 소비자의 특성과 소비행태로 고객을 등급으로 그룹화하고, 그룹의 특성을 가시화하여, 마케팅이나 광고에 활용 가능한 통찰을 제공한다.

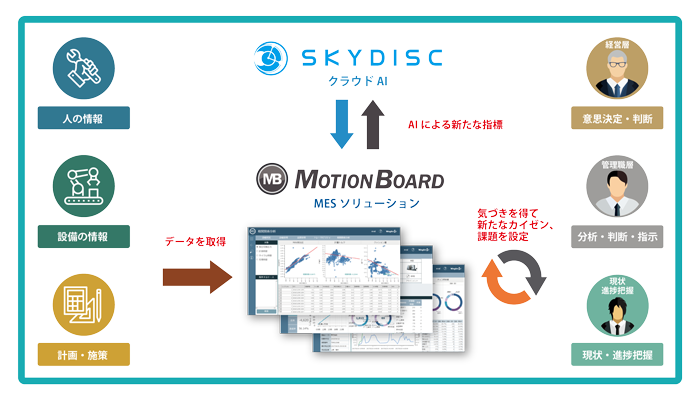

'모션보드 스카이 AI(MotionBoard for SkyAI)'는 일본 스타트업 스카이디스크(Skydisc)에서 제공한 자동차의 부품 제조 결함 탐색 시기와 원인을 판정하는 XAI 기반의 서비스이다. 이 서비스는 성형가공에서 불량품 발생을 예측한 AI의 판정 결과와 결함이 발생했을 때 그 요인이 되는 매개 변수를 실시간으로 시각화하는 것이 특징이다. 또 양품과 불량품의 데이터 비교 및 월·주·일 단위로 생산 데이터의 변화를 그래프로 확인할 수 있다. 일반적으로 AI를 활용하여 검사할 때 기존에는 문제가 일어난 것 같은 시기나 원인만을 보여주지만, 이 서비스에서는 XAI를 활용하여 AI가 어떤 문제에 주목하여 결과를 판단하였는지를 함께 설명한다. 이 서비스는 공장 관리자들에게 하자 발생의 이유를 전달해 공정의 문제점이나 인력 배치를 재검토해 업무를 효율성을 높이는 데 활용될 것으로 기대된다.