[Home] AI로 돌아가기

하이퍼파라미터 (Hyperparameter)

하이퍼파라미터는 인공지능 모델이 학습을 시작하기 전에 사용자가 직접 설정하는 값으로, 모델의 구조나 학습 방식에 영향을 주는 중요한 요소이다. 이러한 값들은 모델이 학습을 통해 자동으로 조정하는 파라미터와는 구별되며, 실험을 통해 적절한 조합을 찾아야 한다.

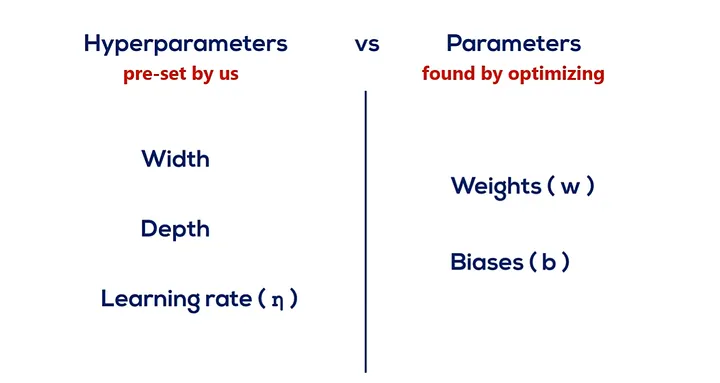

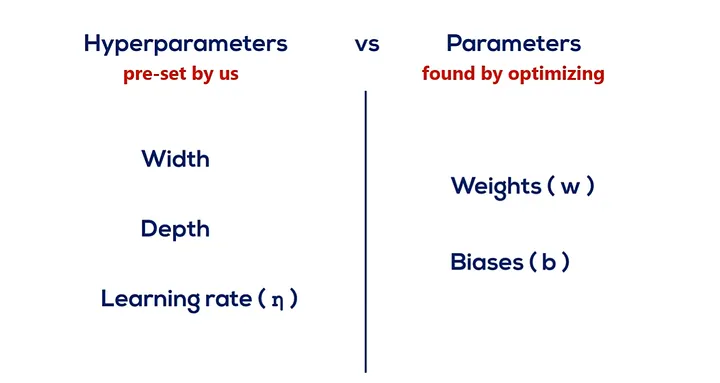

(1) 파라미터와 하이퍼파라미터의 차이

- 파라미터(Parameter)는 모델이 학습을 통해 스스로 조정하는 값으로, 예를 들어 가중치(weight)나 편향(bias) 등이 이에 해당한다.

- 하이퍼파라미터(Hyperparameter)는 학습 전에 사람이 설정해야 하는 값으로, 모델의 학습 방법이나 구조를 결정짓는 역할을 한다.

파라미터와 하이퍼파라미터의 차이(1)

파라미터와 하이퍼파라미터의 차이(1)

출처: https://deepai.org/

파라미터와 하이퍼파라미터의 차이(2)

파라미터와 하이퍼파라미터의 차이(2)

출처: https://medium.com/

(2) 대표적인 하이퍼파라미터

- 학습률 (Learning Rate): 모델이 가중치를 얼마나 빠르게 업데이트할지를 결정하는 값이다. 값이 너무 크면 발산할 수 있고, 너무 작으면 학습 속도가 매우 느려질 수 있다.

- 에포크 수 (Epochs): 전체 학습 데이터를 몇 번 반복해서 학습할지를 나타내며, 일반적으로 여러 번 반복하여 성능을 높인다.

- 배치 크기 (Batch Size): 한 번에 모델에 입력되는 데이터 샘플의 수를 의미하며, 메모리 사용량과 학습 안정성에 영향을 미친다.

- 은닉층 수 및 노드 수: 딥러닝 모델의 구조를 구성하는 요소로, 모델의 표현 능력과 복잡도를 조절한다.

(3) 예시 코드

model = NeuralNet(

learning_rate=0.001,

epochs=50,

batch_size=32,

hidden_layers=[128, 64]

)

※ 위 예시는 하이퍼파라미터를 명시적으로 설정하는 방식의 코드이다.